MLOps a vista de pájaro: Un planteamiento para gobernarlos a todos

April 26, 2024

Seguro que a muchos de los que leen esta entrada os ha venido 'El señor de los Anillos' a la cabeza y, de alguna manera, no está tan desencaminado. El Machine Learning Operations (MLOps) premia el trabajo de todos con un fin común y un gobierno transversal. En esta entrada vamos a hacer una pequeña inmersión en una de las partes fundamentales de MLOps que a muchos nos cuesta ver de primeras.

A modo de recordatorio, MLOps (Machine Learning Operations) proporciona un proceso de desarrollo de modelos de ML de extremo a extremo para diseñar, crear y administrar software basado en modelos de Inteligencia Artificial (IA) que sean reproducibles, testeables y que evoluciones a lo largo del tiempo. Desde Sngular, nos gusta ir un pasito más allá en esta definición y declarar el acrónimo de MLOps como Machine Learning Model Operationalization Management, algo que creemos que es más fiel a la realidad.

Una vez que tenemos claro qué es MLOps, como hemos podido ver en anteriores entradas, podemos definir el Gobierno del Modelo de Aprendizaje Automático como el marco para que una organización controle el acceso, implemente políticas y realice un seguimiento de la actividad de sus modelos de ML. Aquí, como se puede imaginar, entrarían las pruebas, la validación, el control de acceso, la documentación, el seguimiento de los resultados de los modelos y el control de versiones efectivos de los mismos.

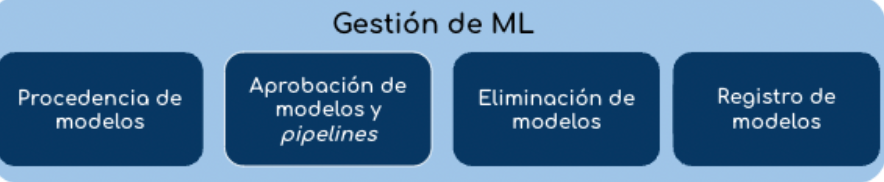

Gestión de Modelos de ML

Cuando una compañía es Data-driven y desea dar un paso más allá con sus datos, utiliza la IA para dar respuestas o construir automatismos que hagan que el negocio crezca. A medida que se llega más lejos en este camino la compañía pasa a adoptar también una filosofía AI-driven y, como consecuencia, la complejidad de cómo productivizar todos los modelos de Machine Learning (ML) se vuelve el principal foco de atención. Las organizaciones necesitan controles para administrar el riesgo e implementar la responsabilidad de los modelos de ML, así como para mantener el cumplimiento de las regulaciones.

Principales procesos a tener en cuenta en ML Management

Principales procesos a tener en cuenta en ML Management

Para que los modelos sean implementados en producción es necesario evaluar y validad la calidad de su efectividad a través de métricas e indicadores de distintas índoles. Tener una gestión de modelos en todo el ciclo de vida de ML ayuda a garantizar lo siguiente:

- Los datos que se recopilan y utilizan para la capacitación y evaluación de modelos son precisos, imparciales y se utilizan de manera adecuada sin violaciones de la privacidad de los datos.

- Es necesario que los problemas en fase de entrenamiento o de predicción sean reproducibles, depurables y rastreables.

- Una evaluación continua de la calidad de los modelos a través de una buena monitorización se convierte en la mejor arma para no descuidar lo que se hace.

- Los modelos se evalúan y validan frente a medidas de la calidad de su efectividad e indicadores de equidad, para que sean aptos para su implementación en producción.

A diferencia de lo que puede pensar la mayoría cuando se plantea utilizar una gobernanza en una fase temprana de adaptación de MLOps en sus compañías, la gestión de los modelos de ML en fase de experimentación o desarrollo no es inmune a ser regularizado. Hacer tracking, tener un control de versionado y la auditabilidad en estas primeras etapas del proceso se convertirá en un beneficio a corto/medio plazo.

Desafíos de la gobernanza del ML

En el momento de plantearse una gestión eficiente de los modelos de ML surgen muchos retos que tenemos que tener en cuenta a la hora de realizar una buena gobernanza. A continuación podemos ver algunos que consideramos en Sngular como fundamentales a tener en cuenta:

- No tener una visión 360 sobre las prácticas y las regulaciones. Dado la poca madurez actual del gobierno de modelos, muchas empresas intentan desarrollar un roadmap de manera acelerada dejando a un lado el entorno regulatorio que, como sabemos, está en contraste evolución. Hay que adelantarse a lo que pueda venir en lugar de pensar que algo no pueda llegar.

- Comunicación e integración con otras políticas. El trabajo previo, en el marco de buenas prácticas y regulación, realizado por los grupos de IT en las compañías no puede ser olvidado. La integración de las prácticas de gobierno de ML con políticas de IT generaría un marco con mejores resultados.

- Una mala imagen es un riesgo de negocio. Imagina que tenemos un modelo que da malas predicciones durante demasiado tiempo. Esto puede hacer que muchos usuarios abandonen nuestra plataforma o generen un feedback negativo a través de comentarios. Hay que tener claro que un modelo que no se supervisa correctamente es una potencial pérdida de confianza de los clientes, y con ello, una pérdida directa en la monetización.

- Converger las soluciones de IA y Datos. Implementar un gobierno de ML adecuado conduce a hacer que coexistan flujos de trabajo y herramientas muy dispares. Velar porque exista armonía es un gran reto que en constante revisión.

¿Por qué es importante un Gobierno de modelos?

Si has llegado hasta aquí seguro que en algunas cosas estás de acuerdo y en otras no. También se te habrá pasado por la cabeza si esto valdrá de algo en tu negocio. Dejemos claro que, a fecha de hoy, la gobernanza de los datos está muy avanzada y sigue automejorando cada día. El auge de la utilización de la Inteligencia Artificial nos conduce a querer una buena gestión de lo que está sucediendo en todo momento en el ciclo de vida de los modelos, tanto en producción como en desarrollo.

Representación de Google Cloud en relación a la gestión de datos y modelos

Representación de Google Cloud en relación a la gestión de datos y modelos

Un beneficio clave de la gobernanza de modelos es su capacidad para identificar claramente quién tiene la propiedad de un modelo, de dónde vienen los datos que utiliza, qué parámetros se están utilizando, en qué contexto se ha creado, etc., y así poder tener una trazabilidad clara en momentos que toque mirar hacia atrás y dar respuestas. Respuestas que ayuden a evitar problemas de sesgos o inexactitud de los modelos, lo que permitirá que se opere sin asumir tanto riesgo. Al final se trata de tener una clara visión del linaje y las capacidades de los modelos.

Que no se nos olvide ser responsables

Hoy en día surgen nuevos conceptos sobre el tapete. La Inteligencia Artificial Explicable (XAI por su siglas en inglés; Explainable Artificial Intelligence) es uno de ellos. La XAI hace alusión al conjunto de métodos y procesos que permiten a los humanos comprender y confiar en los resultados propuestos por un algoritmo de IA. Como se puede entender, esto es un proceso post-facto, es decir, una consecuencia de un acto posterior. Pero ¿qué pasa si yo quiero adelantarme a los acontecimientos? Aquí surge otro nuevo concepto: la Inteligencia Artificial Responsable.

La IA Responsable es la práctica de diseñar, construir e implementar IA de una manera que empodera a las personas y las empresas, y tiene un impacto justo en los clientes y la sociedad, lo que permite a las empresas generar confianza y escalar la IA con seguridad.

Áreas involucradas en MLOps

Áreas involucradas en MLOps

En este punto, nos queda claro que la IA Explicable es parte fundamental para construir una IA Responsable, y la IA Responsable, junto con el gobierno de los modelos, parte nuclear de MLOps. Como vemos en la figura 3, el paradigma MLOps no es sólo un enfoque operacional del ML, sino una gestión y responsabilidad sobre los propios modelos. Esto aumenta la confianza de las partes interesadas en los sistemas de ML al proporcionarles una comprensión de cómo y por qué los modelos hacen ciertas predicciones. Además, ayuda a garantizar que todos los grupos de usuarios estén representados sin prejuicios, con equidad y justicia.

Bibliografía

(B1) “The Framework for ML Governance” por Kyle Gallatin

(B2) “Awesome ML Model Governance” (https://github.com/visenger/Awesome-ML-Model-Governance).

(B3) “Machine Learning for High-Risk Applications” por Patrick Hall, James Curtis, Parul Pandey

Artículo escrito por David González.